Diferencias entre gpt y bert explicadas fácil

En el fascinante mundo de la inteligencia artificial, los modelos como GPT y BERT han revolucionado la forma en que las máquinas procesan y generan lenguaje. GPT, desarrollado por OpenAI, es un modelo generativo que crea texto de manera autónoma, mientras que BERT, creado por Google, se especializa en entender el contexto bidireccional de las palabras. Estos algoritmos de IA, basados en la arquitectura de transformers, han impulsado avances en procesamiento del lenguaje natural (PLN), permitiendo aplicaciones desde chatbots hasta análisis de sentimientos. Si estás interesado en modelos de IA, esta explicación amigable te ayudará a desmitificar las diferencias entre estos dos gigantes. Imagina tener un amigo que te cuenta sobre cómo funcionan estas tecnologías de manera sencilla y accesible, eso es lo que encontrarás aquí. Con un enfoque en algoritmos de IA eficientes, GPT y BERT no solo optimizan el aprendizaje profundo, sino que también abren puertas a innovaciones prácticas en la vida cotidiana.

Entendiendo GPT

GPT, o Generative Pre-trained Transformer, es uno de los modelos de IA más populares para la generación de texto. Este algoritmo de IA utiliza un enfoque predictivo para crear contenido coherente y creativo, lo que lo hace ideal para tareas como escribir artículos o responder preguntas. Con su diseño basado en transformers, GPT aprende patrones del lenguaje a partir de grandes conjuntos de datos, permitiendo una interacción natural con los usuarios.

Arquitectura de GPT

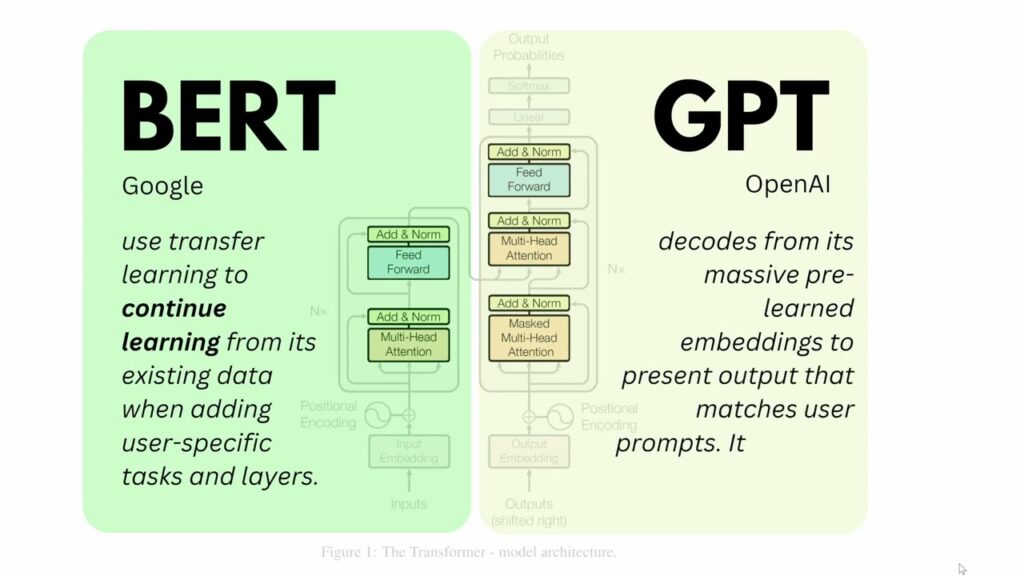

La arquitectura de GPT se basa en una red neuronal transformer con múltiples capas de atención, lo que le permite procesar secuencias de texto de manera secuencial. Este modelo de IA es autoregresivo, es decir, genera palabras una a una basándose en las anteriores, lo que facilita la creación de narrativas fluidas y contextualmente relevantes en algoritmos de IA avanzados.

Funcionamiento de GPT

En su funcionamiento, GPT es entrenado con datos masivos de internet, utilizando técnicas de aprendizaje no supervisado. Una vez entrenado, el modelo puede generar respuestas a partir de un prompt inicial, adaptándose a diversos contextos y lenguajes, lo que lo posiciona como un pilar en los algoritmos de IA para aplicaciones creativas y dinámicas.

Qué es el fine-tuning de modelos de lenguajeEntendiendo BERT

BERT, que significa Bidirectional Encoder Representations from Transformers, es un modelo de IA diseñado para comprender el contexto completo de una oración. A diferencia de otros algoritmos de IA, BERT analiza el texto en ambas direcciones, lo que mejora la precisión en tareas como la búsqueda semántica o la respuesta a preguntas. Este enfoque bidireccional lo hace especialmente útil para aplicaciones que requieren una comprensión profunda del lenguaje natural.

Arquitectura de BERT

La arquitectura de BERT incluye un encoder transformer que procesa el texto de manera simultánea, capturando relaciones entre palabras en un contexto bidireccional. Este diseño en modelos de IA permite una representación más rica y contextualizada, superando limitaciones de métodos anteriores en algoritmos de IA orientados al procesamiento del lenguaje.

Funcionamiento de BERT

En su funcionamiento, BERT se entrena con técnicas como el enmascaramiento de palabras y la predicción de la siguiente oración, lo que le enseña a inferir significados ocultos. Como resultado, este algoritmo de IA es altamente efectivo para tareas de comprensión, como clasificar texto o extraer información relevante de grandes volúmenes de datos.

Diferencias clave entre GPT y BERT

Al comparar GPT y BERT, vemos que ambos son modelos de IA basados en transformers, pero difieren en su enfoque principal: GPT se centra en la generación, mientras que BERT prioriza la comprensión. Estas diferencias en algoritmos de IA afectan su rendimiento en diversas aplicaciones, haciendo que cada uno sea más adecuado para escenarios específicos, como la creación de contenido versus el análisis detallado.

Cómo funciona el algoritmo de refuerzo en iaEnfoques de entrenamiento

Los enfoques de entrenamiento en GPT son predictivos y autoregresivos, enfocándose en predecir la siguiente palabra, lo que lo hace más orientado a la creatividad. En contraste, BERT utiliza un entrenamiento bidireccional que enmascara partes del texto para aprender contextos, destacando su rol en modelos de IA para tareas de comprensión profunda y precisa.

Aplicaciones y usos

En términos de aplicaciones, GPT brilla en la generación de texto, como en chatbots o redacción automática, mientras que BERT es preferido para la búsqueda y el análisis, como en motores de búsqueda o sistemas de recomendación. Estas variaciones en algoritmos de IA permiten a los desarrolladores elegir el modelo adecuado según las necesidades específicas de procesamiento del lenguaje natural.

En resumen, GPT y BERT representan avances significativos en los modelos y algoritmos de IA, cada uno con fortalezas únicas que enriquecen el panorama de la inteligencia artificial. Mientras GPT fomenta la creatividad y la generación ilimitada, BERT ofrece una comprensión contextual profunda, permitiendo innovaciones en diversos campos. Ya sea que estés explorando el PLN por curiosidad o por trabajo, entender estas diferencias te ayudará a aplicar estos herramientas de manera efectiva. ¡Explora más sobre algoritmos de IA hoy y descubre cómo puedes integrarlos en tus proyectos!

Usos del algoritmo naïve bayes en la prácticaSi quieres conocer otros artículos parecidos a Diferencias entre gpt y bert explicadas fácil puedes visitar la categoría Modelos.

Entradas Relacionadas